Fake Future #1: Deepfake Videos

01.07.2022

Wir lieben es, an der Spitze zu sein. Ob es neue Methoden der Werbebetrugsbekämpfung, Bot-Verkehr oder neue Technologien sind, die das Potenzial haben, die Welt zu verändern.

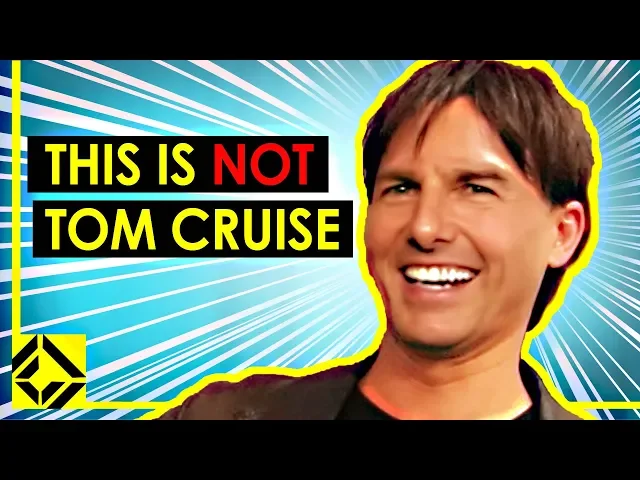

Eine dieser Technologien sind Deepfakes. Meistens kurze Videos, die im Social-Media-Feed angezeigt oder von jemand anderem weitergeleitet werden – Ja Mama, ich habe Tom Cruises verrückten Kanal auf TikTok gesehen und kann es selbst nicht glauben.

Dieser Artikel ist Teil einer dreiteiligen Serie über Deepfakes, die jeweils eine spezielle Form von Deepfakes abdeckt. Mit dieser Artikelserie möchten wir dich auf eine Reise in computererzeugte Bilder und Videos mitnehmen, die teilweise sehr verrückt sind und ernsthafte Auswirkungen auf die Menschheit haben könnten.

Dieser Artikel konzentriert sich auf Deepfake-Videos, was sie sind, wie sie erstellt werden und welche Auswirkungen diese Technologie auf die Gesellschaft als Ganzes haben kann.

Was sind Deepfakes?

Deepfakes nutzen eine Form von künstlicher Intelligenz namens Deep Learning, um gefälschte Bilder, Audio oder Videos zu erstellen – daher der Name Deepfake. Deep-Learning-Algorithmen sind in der Lage, sich selbst beizubringen, Probleme zu lösen, wenn ihnen eine große Datenmenge gegeben wird.

Selbst wenn du den Namen nicht kennst, gibt es eine gute Chance, dass du bereits ein Deepfake-Video gesehen hast. Die bekanntesten Videos umfassen:

Präsident Nixon hält die Rede „In Event of Moon Disaster“, in der Neil Armstrong und Edwin Aldrin von ihrer Mondmission nicht zurückkehren.

Wie werden Deepfakes erstellt?

Video- und Bildmanipulation gibt es seit mehreren Jahrzehnten. Es war 2017, als ein Benutzer namens „Deepfakes“ manipulierte Erwachsenenfilme auf Reddit postete. Das Video tauschte die Gesichter von Schauspielerinnen mit Prominenten wie Taylor Swift und Gal Gadot.

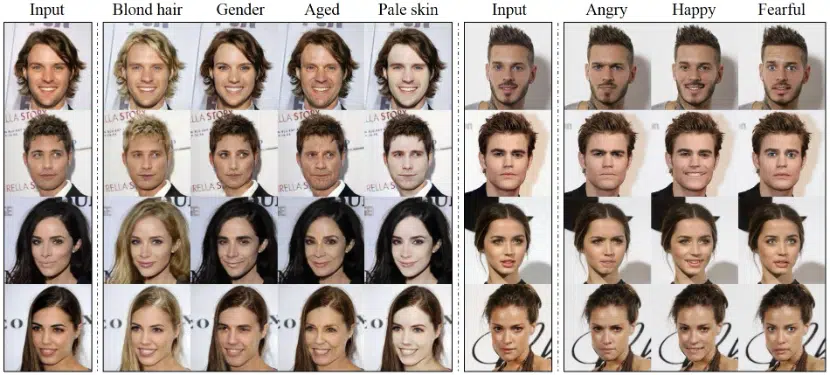

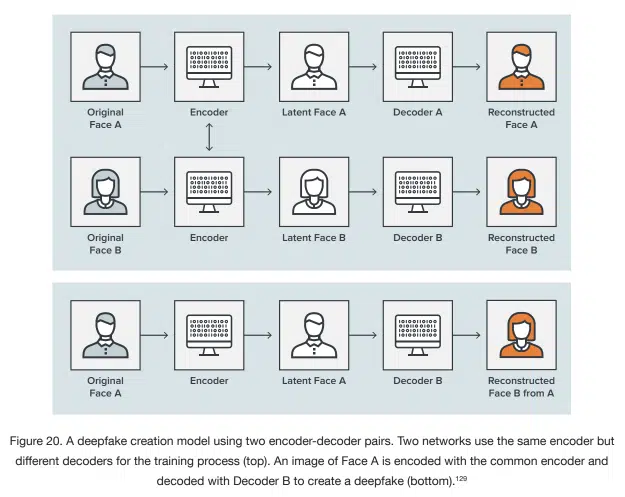

Aber wie genau tauscht man die Gesichter von Personen in einem Video aus? Es gibt mehrere Techniken, die maschinelle Lernalgorithmen verwenden, um die Aufgabe zu bewältigen. Sie basieren auf Autoencodern und manchmal sogar auf noch ausgeklügelteren Generativen Gegnernetzen (GANs). Beide haben gemeinsam, dass sie zuerst auf einem Datensatz trainiert werden müssen, um in der Lage zu sein, einen Teil des Gesichts einer Person zu ersetzen.

Am Anfang steht Daten – viele Daten. Du brauchst Bilder vom Gesicht der Person, die du mit einer anderen austauschen möchtest. Um das Ergebnis zu verbessern, benötigst du mehrere Tausend dieser Bilder in allen Szenarien wie helle und dunkle Belichtung, Frontal- und Seitenansicht, und auch mit unterschiedlichen Gesichtsausdrücken. Bei Prominenten ist es leichter zu realisieren, da Tausende von Fotos von ihnen im Internet, in verschiedenen Fotodatenbanken und durch Interviews erhältlich sind.

Autoencoder

Um es so einfach wie möglich zu halten: Autoencoder sind eine Familie von selbstüberwachten neuronalen Netzen, die lernen, wie man ihren Input repliziert. Sie bestehen aus drei Hauptkomponenten: einem Encoder, einem Code und einem Decoder.

Der Encoder sucht nach Ähnlichkeiten zwischen den beiden Gesichtern, die du austauschen willst, und reduziert sie auf ihre gemeinsamen Merkmale. Er komprimiert die Eingabedaten und generiert den Code, den der Decoder im weiteren Prozess verwendet.

Nachdem der Encoder seine Arbeit erledigt hat, übernimmt der Decoder. Dieser Algorithmus ist darin trainiert, Gesichter aus den vom Encoder erzeugten komprimierten Bildern wiederherzustellen. Du musst zwei verschiedene Decoder trainieren: einen, der das Gesicht der Originalperson wiederherstellt und einen anderen, der das Gesicht wiederherstellt, das du ersetzen möchtest.

Alles, was du jetzt tun musst, ist, die komprimierten Bilder in den „falschen“ Decoder einzuspeisen: Das Gesicht der Originalperson wird in den Decoder eingegeben, der auf dem Gesicht der Person trainiert ist, das du austauschen möchtest – das „Fake“. Der Decoder kann dann das „Fake“-Gesicht mit den Ausdrücken und der Orientierung des Originalgesichts rekonstruieren.

Generative Adversarial Networks (GANs)

Die zweite Methode, um Deepfakes zu erstellen, ist die Verwendung von Generativen Gegnernetzen. Dieser Ansatz lässt zwei verschiedene neuronale Netze gegeneinander antreten: den Generator und den Diskriminator.

Der Generator lernt autonom, Regelmäßigkeiten und Muster in einem Eingabedatensatz nachzubilden. Diese reproduzierten Daten werden dann zusammen mit echten Daten zur Bewertung an den Diskriminator gesendet.

Der Diskriminator betrachtet die Daten und versucht, die reproduzierten „Fake“-Daten des Generators im Datensatz zu erkennen und gibt Feedback zur Leistung. Das Ziel des Generators ist es, den Diskriminator so zu täuschen, dass er nicht mehr zwischen echten und reproduzierten Daten unterscheiden kann.

Das Hin und Her zwischen Generator und Diskriminator wird unzählige Male wiederholt, wodurch sich das Ergebnis mit jedem Zyklus verbessert, bis der Generator realistische Gesichter erzeugt von nicht existierenden Menschen und damit den Diskriminator erfolgreich täuscht.

Aufgrund des erhöhten Aufwands, der zum Trainieren der Modelle erforderlich ist, und des Bedarfs an mehr Computerressourcen, werden GANs häufig nur verwendet, um Fotos und nicht Videos zu generieren.

Im folgenden Video kannst du sehen, wie man ein vollständiges Deepfake-Video mit dem Gesicht von Tom Cruise erstellt:

Geht es bei Deepfakes nur um Videos?

Nein. Die Deepfake-Technologie kann auch fiktive Fotos und Stimmklone von Grund auf erstellen.

Ein Beispiel für fiktive Fotos ist die Website this-person-does-not-exist.com, die real aussehende Fotos von Menschen zeigt, die nicht existieren. Die KI wurde mit Tausenden von Profilbildern trainiert und weiß, wie man realistische Gesichter zeichnet. Diese Bilder werden dann von Unternehmen auf LinkedIn verwendet, um beispielsweise gefälschte Profile zu erstellen, um ihre Vertriebsmitarbeiter zu unterstützen und Algorithmen zu umgehen, die die Sichtbarkeit einschränken könnten.

Laut dem neuesten Transparenzbericht hat LinkedIn im Jahr 2021 über 30 Millionen gefälschte Konten entfernt, einige davon aufgrund von computergenerierten Profilbildern.

Ein weiteres Beispiel für einen Deepfake-Ton wurde in Disneys Serie The Mandalorian implementiert. Mit einer Anwendung namens Respeecher konnte das Filmteam die Stimme des jungen Luke Skywalker vollständig klonen. Die KI wurde mit früheren Radiosendungen und Interviews mit der Stimme von Mark Hamill trainiert, um die gewünschten Ergebnisse zu erzielen. Die Ergebnisse waren so gut, dass sie über 9 Monate zwischen der Veröffentlichung von Staffel 2 und der begleitenden Dokumentation unbemerkt blieben.

Welche Technik brauchst du, um Deepfake-Videos zu erstellen?

So schwierig und kompliziert das Erstellen eines Deepfake-Videos auch klingen mag, in Wahrheit ist es sehr einfach. Mit dem Fortschritt der Technologie werden Computer immer schneller, sodass es heutzutage sogar möglich ist, ein solches Video zu Hause zu erstellen. Alles, was du brauchst, ist ein halbwegs leistungsfähiger Computer mit einer schnellen Grafikkarte. Für anspruchsvollere Videos gibt es auch cloudbasierte Rechenzentren, die dir mehr Power bieten.

Du musst auch nicht die entsprechenden Modelle und Algorithmen selbst entwickeln, sondern kannst auf frei verfügbare Open-Source-Software zurückgreifen:

Alles, was du brauchst, sind grundlegende Programmierkenntnisse, um die Tools zum Laufen zu bringen und die entsprechenden Parameter festzulegen.

Aber heutzutage brauchst du nicht einmal einen Computer. Du kannst auch Deepfake-Videos mit deinem Smartphone erstellen. Es gibt einige Apps, mit denen du dein Gesicht auf Memes und sogar Social-Media-Videos bearbeiten kannst:

Wofür werden Deepfake-Videos verwendet?

Wie bei vielen Technologien ist es nicht überraschend, dass Deepfake-Videos ihre erste Verbreitung auch durch die Pornoindustrie fanden. Gesichter weiblicher Prominenter, darunter Emma Watson, Jennifer Lawrence und Daisy Ridley, wurden auf Schauspielerinnen platziert.

Die nächste Phase betraf auch Frauen, die mit den Staatsoberhäuptern verschiedener Länder in Verbindung gebracht wurden, wie Michelle Obama oder Kate Middleton.

Nach den nackten Prominenten waren Politiker die nächste Zielgruppe von Fake-Videos. Das wohl berühmteste Video stammt von Buzzfeed, in dem Präsident Barack Obama Donald Trump einen Trottel nennt. In einem anderen Video, das zugegebenermaßen sofort als Fälschung an Mund und Synchronisation erkennbar ist, macht sich Donald Trump über Belgiens Mitgliedschaft im Pariser Klimaabkommen lustig.

Der neuste politische Skandal im Zusammenhang mit Deepfakes betraf Berlins Bürgermeisterin Franziska Giffey, die offenbar ein Videotelefonat mit einem Fake des Kiewer Bürgermeisters Vitali Klitschko führte.

Aber werden alle Deepfake-Videos für böswillige Zwecke erstellt? Auf keinen Fall! Unten sind einige Anwendungsfälle für Deepfakes. Einige sind moralisch fragwürdig, wie die oben genannten, andere nutzen die neue Technologie für Unterhaltung und sogar Bildung.

Kunst

Das Dali Museum in St. Petersburg, Florida, nutzte die Deepfake-Technologie, um den „Meister des Surrealismus“ wieder zum Leben zu erwecken. Mithilfe von über 6.000 Bildern von ihm und dem Training des Modells über 1.000 Stunden lernte die künstliche Intelligenz, wie er aussah und wie sich Mund und Augen bewegten.

Das Ergebnis sind 45 Minuten neues Filmmaterial, aufgeteilt in 125 kurze Videos, die Besucher ansehen können. Mit 190.512 möglichen Kombinationen sind die Erlebnisse der Besucher praktisch einzigartig. Eine eingebaute Kamera macht auch Selfies mit Dali möglich.

Dies ist ein hervorragendes Beispiel dafür, wie KI und insbesondere Deepfakes den Menschen nicht nur Unterhaltung und unvergessliche Erlebnisse bieten können, sondern auch, wie diese Technologie für bildende und sinnvolle Zwecke eingesetzt werden kann.

Film-/Medienbranche

Wahrscheinlich hast du bereits einen Film gesehen, in dem Deepfake-Technologie verwendet wurde. Die häufigste Verwendung von Deepfakes ist, wenn die Schauspieler bereits verstorben sind. Dies geschah mit Carrie Fisher oder Peter Cushing, die beide in „Star Wars: Rogue One“ auftauchten. Es gibt auch Pläne, um James Dean für einen neuen Film wiederzubeleben.

Ein weiteres Beispiel für den Einsatz in der Filmbranche ist die Verjüngung von Schauspielern. In „The Irishman“ haben Robert De Niro, Al Pacino und Joe Pesci eine Verjüngungskur erhalten.

Sind Deepfakes sogar in der Lage, menschliche Schauspieler in der Zukunft vollständig zu ersetzen? Wer weiß, aber wahrscheinlich nicht vollständig. Das Beispiel des südkoreanischen Senders MBN zeigt jedoch, dass es durchaus möglich ist, eine Person vollständig zu ersetzen.

Letztes Jahr wurde die Nachrichtenmoderatorin Kim Joo-Ha während einer Sendung durch ein Deepfake von sich selbst ersetzt. MBN hat bereits zugegeben, dass sie planen, das System in Zukunft für aktuelle Nachrichten weiterhin zu nutzen.

Anonymität

Um die Identitäten schwuler Tschetschenen zu schützen, deren sexuelle Orientierung in ihrem Heimatland zu Folter und Tod führen kann, verwendeten Filmemacher Deepfakes in der HBO-Dokumentation „Welcome to Chechnya“ im Jahr 2020. Anstatt traditioneller anonymer Silhouette-Interviews erhalten die Zuschauer einen intimen Einblick in das Leben schwuler Tschetschenen, die vor Verfolgung fliehen. Ohne Deepfake-Technologie wäre eine solche Dokumentation weniger überzeugend und bewegend gewesen.

Erpressung

Naturally, diese Technologie wird bereits von Betrügern genutzt, um Menschen zu erpressen. In einem Fall richteten die Betrüger Fake-Profile auf Online-Datingseiten ein und gaben vor, Frauen zu sein. Sie schickten dann Freundschaftsanfragen an Männer und überredeten sie, einen Videoanruf zu machen. Während des Gesprächs wurde ein computergeneriertes Video einer Frau verwendet, um das Opfer zum Onanieren zu verleiten. Die Betrüger nahmen natürlich alles auf, und das Opfer erhielt danach einen Erpresseranruf.

Wenn das Opfer sich weigert zu zahlen, beginnt Phase 2. Die Betrüger verwenden ein Foto des Opfers, das während des Videoanrufs aufgenommen wurde, und produzieren ein zweites Deepfake-Video, das das Opfer bei einem sexuellen Akt zeigt. So setzt sich der Betrug fort.

Modebranche

Modeunternehmen stehen derzeit vor einem großen Problem: Neue Produkte müssen so schnell wie möglich vom Planungstisch auf den Markt gebracht werden, um den Fast-Fashion-Anhängern gerecht zu werden. Allein die Zeit für Fotoshootings der Kleidung kann einige Wochen dauern. Models müssen gecastet, Stylisten gefunden, Fotografen engagiert und alle Kleidungsstücke physisch an einem Ort vorhanden sein, damit das Shooting stattfinden kann.

Aber auch hier könnten Deepfakes eine Lösung bieten. Looklet bietet virtuelle Models an, die beliebige Kleidung in verschiedenen Posen tragen können. Der Hersteller muss jetzt nur noch jedes Kleidungsstück auf einer Schaufensterpuppe fotografieren und das Bild hochladen. Unabhängig vom Produktionsstandort oder anderen Dienstleistern. Hersteller können aus einer Vielzahl verschiedener Models wählen – einschließlich Kinder- und Plus-Size-Models – und ihre Stücke schnell und einfach auf ihrer Website präsentieren.

Potentielle Bedrohungen durch Deepfake-Videos

Obwohl die Deepfake-Technologie viele legitime Anwendungsfälle hat, gibt es auch potenzielle Gefahren, die entstehen können. Europol und UNICRI haben mehrere Szenarien möglicher zukünftiger Bedrohungen durch Deepfakes identifiziert. Dazu gehören:

Desinformationskampagnen

Wertpapierbetrug

Erpressung

Online-Verbrechen gegen Kinder

Behinderung der Justiz

Kryptojacking

Illegale Märkte

Für mehr Informationen und Beispiele zu jedem Szenario, lies hier den vollständigen Bericht.

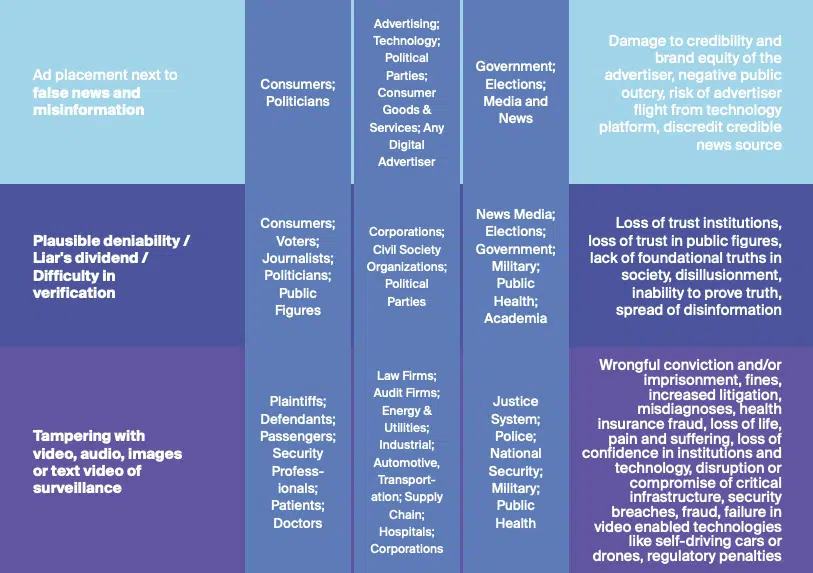

Ein weiterer lesenswerter Bericht von Deeptrust Alliance listet auch potenzielle Bedrohungen für Einzelpersonen und Organisationen auf. Eine identifizierte Bedrohung dreht sich um die Anzeigenplatzierung neben Fake News.

Wie erkennt man ein Deepfake-Video?

Da die Deepfake-Algorithmen immer besser darin werden, realistische Videos zu erstellen, wird es immer schwieriger, sie von echten zu unterscheiden. Ironischerweise könnte künstliche Intelligenz die Antwort sein, um von einer anderen KI erstellte Fake-Videos zu erkennen.

KI kann Anzeichen und Unregelmäßigkeiten erkennen, die im Video nicht echt sind und leicht vom menschlichen Auge übersehen werden könnten. Vor ein paar Jahren war ein ungewöhnliches Blinzeln der Augen ein gutes Zeichen für ein Deepfake-Video. Aber sobald das Forschungspapier veröffentlicht wurde, wurden die Algorithmen verbessert und konnten das Blinzeln realistisch darstellen.

Achte auf folgende Anzeichen, wenn du versuchst, zu erkennen, ob ein Video fake ist oder nicht:

Lichtverhältnisse sind off

Merkwürdige Schatten

Schwankungen in der Hautfarbe oder unrealistische Hautfarbe

Inkonsistenzen beim Sprecher

Ruckartige Bewegungen

Zusätzliche Pixel

Mehrfache Lichtreflexion in den Augen

Da eine manuelle Überprüfung nicht nur sehr fehleranfällig, sondern auch aufgrund des großen Volumens an Deepfake-Videos unpraktisch wäre, muss eine technische und automatisierte Lösung gefunden werden. Einige internationale Unternehmen, Universitäten und Regierungen haben bereits den Hackaton for Peace, Justice and Security 2019 abgehalten, um genau dieses Problem zu lösen.

Microsoft, Facebook und Amazon haben ebenfalls gemeinsam eine Deepfake Detection Challenge abgehalten, um eine Lösung zum automatischen Erkennen von Deepfake-Videos zu finden. Leider ließen die Ergebnisse noch zu wünschen übrig. Das beste Modell hatte nur eine Erkennungsrate von 65 % – zu schlecht, um derzeit produktiv eingesetzt zu werden.

Aber trotzdem gibt es heutzutage einige Tools und Techniken, die sich dieses Problems angenommen haben und ihre Modelle kontinuierlich verbessern:

Du kannst fragliche Videos online mit deepware.ai scannen, um herauszufinden, ob sie synthetisch manipuliert sind

Microsoft arbeitet daran, Desinformationen zu bekämpfen, aber das Tool ist derzeit nicht für die Öffentlichkeit zugänglich

Forscher sind in der Lage biologische Signale aus dem Video zu erkennen und falsche Herzschläge zu erkennen

Durch Analyse der Lichtreflexionen in den Augen kann ein Tool erkennen, ob ein Video ein Deepfake ist oder nicht

Eine andere Technik nutzt die Tatsache, dass Viseme, die die Dynamik der Mundform bezeichnen, manchmal von den gesprochenen Phonemen abweichen oder inkonsistent sind.

Operation Minerva ist ein System, das Deepfake-Pornos erkennen und automatisch eine Benachrichtigung zur Löschung senden kann

Derzeit gibt es keine technische Lösung, um effektiv und genau zu erkennen, ob ein Video fake ist oder nicht. Wie bei so vielen anderen Technologien wird es ein Kopf-an-Kopf-Rennen. Auf der einen Seite gibt es Entwickler, die Modelle trainieren, um die realistischsten Ergebnisse zu liefern und Erkennungsmechanismen auszutricksen. Auf der anderen Seite stehen Forscher, Regierungen und große Plattformen, die Fake-Videos zuverlässig erkennen und deren potenziell gefährliche Verbreitung verhindern möchten.

Was sagt das Gesetz über Deepfake-Videos?

Deepfake-Videos zu erstellen, ist nicht per se illegal. Es gibt jedoch einige Länder, die aktiv gegen die Verbreitung von Deepfakes vorgehen. China hat beispielsweise Anfang 2022 ein Gesetz erlassen, das großen Plattformen wie TikTok, die große Datenmengen verwenden, um ihre Inhalte zu personalisieren, verbietet, Nutzern Fake-Videos in ihrem Newsfeed anzuzeigen. Die Vorschriften zielen auf die Verbreitung falscher Informationen ab, die zu Betrug oder sozialer Instabilität führen könnten.

Ein weiteres Beispiel sind Texas und Kalifornien. Beide Staaten haben politisch motivierte Deepfake-Videos innerhalb von 30 Tagen vor einer Wahl verboten. Ähnlich wie Virginia hat auch Kalifornien Deepfake-Pornografie verboten.

Aber das größte Problem dürfte der Mangel an Gerichtsbarkeit über extraterritoriale Urheber von Deepfakes sein. Es kann so viele Gesetze geben, wie es gibt, wenn sie nicht auf den Ersteller der Videos zutreffen, weil die Person in einem anderen Land sitzt.

„Daher können einstweilige Verfügungen gegen Deepfakes nur unter wenigen spezifischen Umständen erteilt werden, einschließlich Obszönität und Urheberrechtsverletzung.“ (Quelle)

Was ist die Zukunft der Deepfakes?

Ähnlich wie die Computeranimation (CGI) in den frühen 90ern sind Deepfakes eine bahnbrechende Technologie, aber mit größerem Missbrauchspotenzial. Einige sagen vielleicht sogar, dass Deepfakes Chaos verursachen und das Vertrauen untergraben werden.

Viele Unternehmen arbeiten bereits an Deepfake-Modellen, die nicht eine große Menge an Daten als Input benötigen, sondern mit nur einem einzigen Bild arbeiten können. Samsung hat es beispielsweise geschafft, die Mona Lisa zum Leben zu erwecken mit ihrer Technologie.

Andere Unternehmen wie Synthesia arbeiten an einem Komplettpaket. Künstliche Intelligenz wird verwendet, um Videos komplett mit Sprechern und Sprachausgabe aus reinen Textdokumenten zu generieren. Kunden können aus einer Reihe verschiedener Sprecher einschließlich verschiedener Dialekte wählen oder sich selbst als virtuellen Avatar erstellen, falls gewünscht. Danach braucht es nur noch den Text, der im Video gesprochen werden soll, und das System erledigt den Rest von allein.

Es wird auch interessant zu sehen sein, wie verschiedene Regierungen auf die potenzielle Bedrohung reagieren und in Zukunft mit der Technologie umgehen.

Was auch immer die Zukunft für Deepfakes bereithält, eines ist sicher: Deepfake-Videos sind gekommen, um zu bleiben.